Системы для распознавания реакций человека, его эмоций и душевного состояния, в той или иной форме уже используются в разных крупных компаниях. Например, в IBM и Unilever они помогают проводить тестирование соискателей на разные должности, в Disney искусственный интеллект изучает эмоции зрителей в зале для оценки новых фильмов, продукты от Microsoft показывают реакцию учеников на подачу учебного материала учителем. Но недавно эту сферу потряс серьезный скандал.

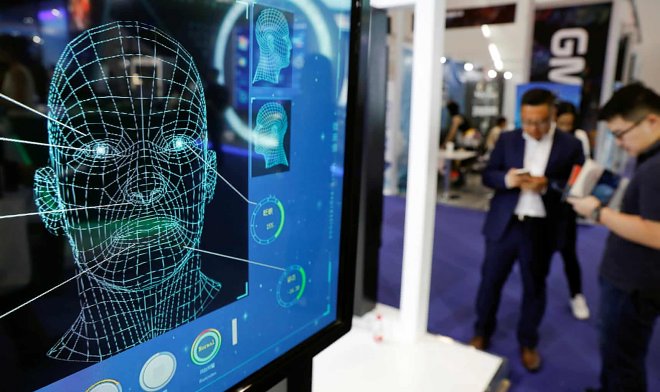

Любая система распознавания эмоций состоит из двух модулей. Первый – камера с компьютерным зрением, которая анализирует поведение человека и распознает его жесты и мимику. Вторым модулем выступает профильный ИИ, которые на основе данных о текущих действиях человека и сведений о ситуации должен принять решение, что происходит в его голове. Дать оценку поведению, сделать выводы о склонностях испытуемого, проверить его на соответствие критериям поставленной задачи.

В начале зимы исследователи из Университета Уэйк Форест опубликовали данные о крупном недостатке подобного анализатора эмоций от Microsoft. Эта система при анализе мимики всегда занижала оценки для соискателей с темным цветом кожи. Даже если они искренне улыбались, ИИ ставил ярлык «обманщик», мог существенно снизить оценки умственного развития человека. Словом, демонстрировал почти полный шаблон расовых предрассудков, причем в отношении светлокожих людей этого не происходило.

А теперь, спустя несколько месяцев, схожие проблемы нашлись во многих других системах по распознаванию эмоций и даже образов людей. Алгоритмы сбоят тем чаще, чем более темный оттенок кожи у конкретного человека, вплоть до того, что бортовой ИИ некоторых беспилотных авто не воспринимал темнокожих пешеходов как живых существ. Вряд ли это чья-то масштабная шутка или заговор, скорее, вопрос в подборке данных для обучения ИИ на начальном этапе. И это может оказаться большой проблемой.

antfor.ru

antfor.ru