У каждого дипфейка должно быть благое обоснование, по крайней мере, на первых порах. Вот и новая разработка Adobe Research, в сотрудничестве с учеными из Стенфорда и Института Макса Планка преследует цель минимизировать затраты времени и съемок видео за счет применения дипфейка. С его помощью можно вложить в уста человека на записанном видео какой угодно текст так, как если бы он реально его озвучил, а не записывать десятки неудачных дублей при реальных съемках.

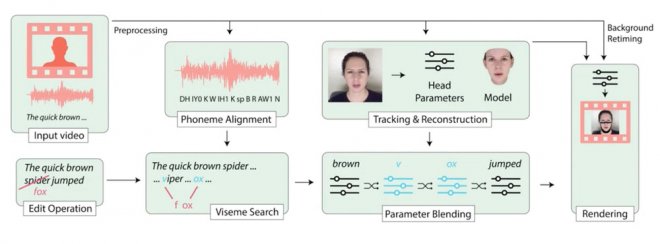

Для работы нейросети нужно не менее 40 минут оригинального видео со стенограммой того, что озвучивает диктор. Программа изучает его мимику, сопоставляет фрагменты текста с движениями мышц и строит трехмерную модель «говорящей головы». Дело за малым – составить последовательность жестов под новый текст, сгенерировать нужные текстуры и наложить их на модель.

В этой системе применяется технология машинного обучения Neural Rendering, которая ответственна за фотореалистичное изображение. Для добавления звука в видео нужен дополнительный модуль, например, сервис VoCo, который работает по схожей схеме. Появление данного дипфейка не стало сенсацией и уже даже не вызывает удивление на фоне прочих достижений в этой сфере. Интереснее другое: создатели дипфейка сами признают, что готовят оружие для информационной войны, и выстрелит оно совсем скоро – на выборах президента США в 2020-ом.

Точнее, разработчики опасаются такого развития ситуации и поэтому хотят опередить его, познакомить мир с дипфейком для идеального саботажа новостных выпусков и различных «утечек данных». Чтобы мир, якобы, успел привыкнуть и попытался выработать иммунитет к нему. Или хотя бы подстегнуть работу по созданию методов обнаружения дипфейков, разработать новые способы расследования и определения, где правда, а где ложь. Увы, сама суть генеративно-состязательных нейросетей как раз в том, чтобы раз за разом создавать все более реалистичные фейки. И в этом машины давно превзошли нас, людей.

antfor.ru

antfor.ru